OpenAI دو مدل پیشرفته هوش مصنوعی خود به نام های o3 و o3 mini را در اطلاعیه های “Days of OpenAI 12” معرفی کرد. پایان دادن

مدل های مینی هوش مصنوعی OpenAI o3 و o3

o3 و o3 mini به عنوان مدل های پیشرفته استنتاج OpenAI معرفی شدند که اوایل امسال همراه با مدل o1 منتشر شدند. جالب توجه است که OpenAI از استفاده از آدرس “o2” برای جلوگیری از درگیری یا سردرگمی احتمالی با شرکت مخابرات بریتانیا O2 اجتناب کرده است.

مدل O3: تعیین استانداردهای جدید در تفکر و هوش

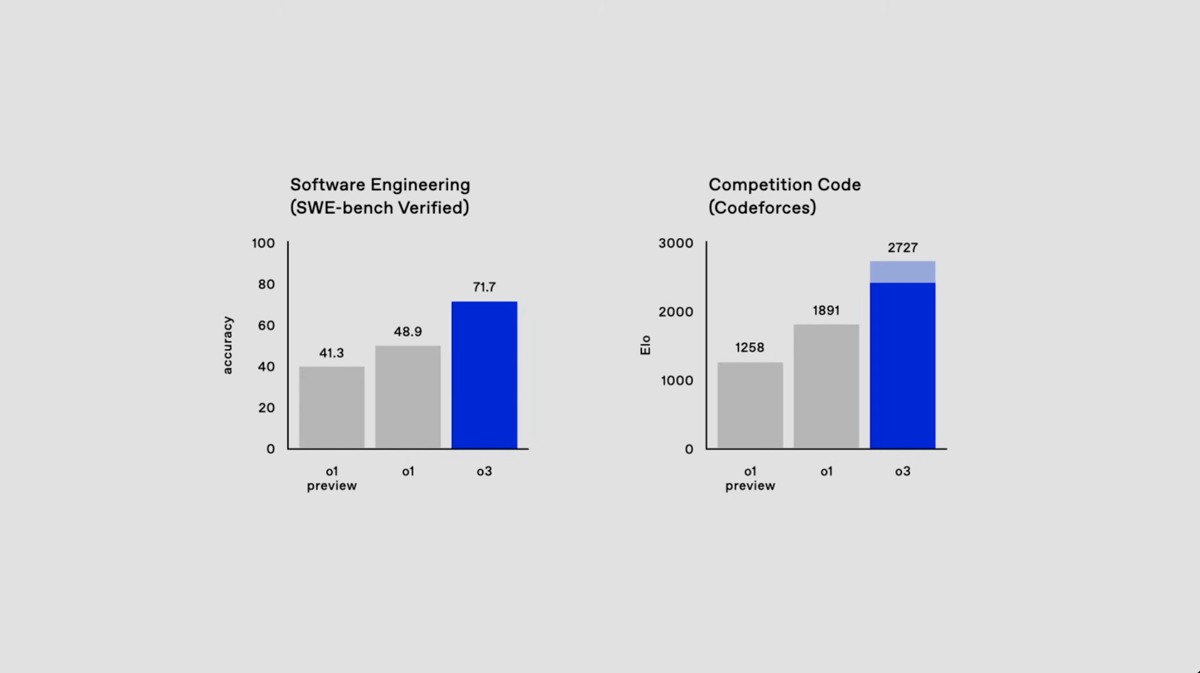

مدل O3 استاندارد جدیدی برای استدلال و هوش ایجاد می کند و در چندین زمینه از مدل قبلی خود بهتر عمل می کند:

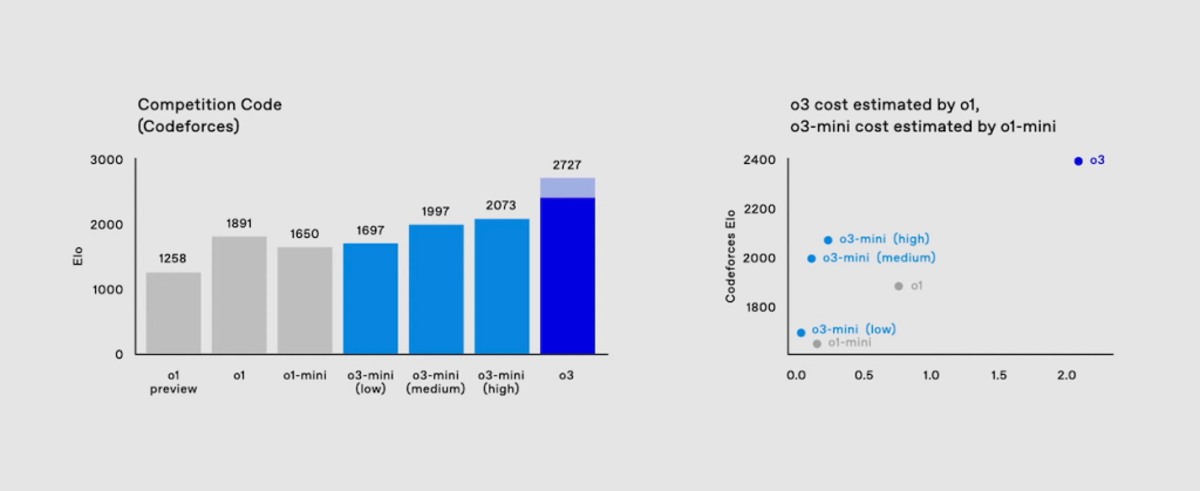

کد نویسی: برای بهبود 22.8 درصد در آزمون های کدگذاری تایید شده SWE-Bench در مقایسه با o1 به دست آمد.

ریاضیات: تقریباً در آزمون AIME 2024 با نتیجه 96.7 درصد او شرکت کرد و فقط یک سوال را از دست داد.

علوم عمومی: یک نتیجه 87.7 درصد تست تضمینی GPQA Diamond که مشکلات علمی را در سطح متخصص ارزیابی می کند.

استاندارد ARC-AGI: با کسب امتیاز 87.5 درصد در شرایط محاسباتی بالا، این سیستم خط ایمنی پنج ساله استاندارد ARC-AGI را شکست و از آستانه 85 درصدی انسان فراتر رفت.

مقیاس ARC-AGI هوش تعمیم یافته را با آزمایش توانایی یک مدل برای حل مسائل جدید بدون تکیه بر الگوهای حفظ شده ارزیابی می کند. با این دستاورد، OpenAI مدل o3 را گامی مهم در جهت دستیابی به این هدف می داند هوش عمومی مصنوعی (AGI) توصیف می کند

مدل های مینی هوش مصنوعی OpenAI o3 و o3

o3 Mini: یک جایگزین فشرده و مقرون به صرفه

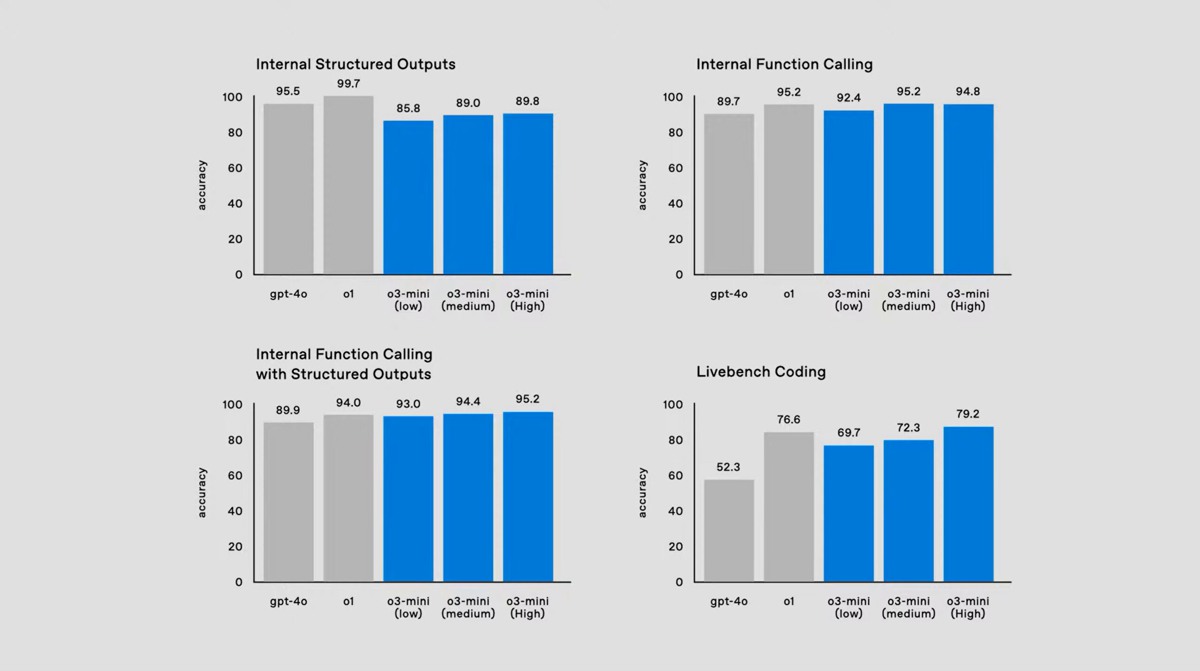

o3 mini نسخه ویژه ای از o3 را ارائه می دهد بهره وری و مقرون به صرفه بودن بهینه:

به کد نویسی و عملکرد سریعتر طراحی شد.

دارای سه تنظیمات حساب کاربری است: کمی، وسط و زیاد.

در تنظیمات متوسط محاسباتی از مدل O1 بهتر عمل می کند و هزینه ها و تاخیر را کاهش می دهد.

OpenAI نیز همسویی مشورتی همچنین یک مدل آموزشی جدید معرفی کرد که هدف آن بهبود ایمنی با ترکیب تفکر ساختاریافته با استانداردهای ایمنی نوشته شده توسط انسان است. جنبه های کلیدی عبارتند از:

مدلها به صراحت در منطق زنجیره فکر (CoT) که با سیاستهای OpenAI همسو میشود، درگیر میشوند.

این نیاز به دادههای CoT برچسبگذاری شده توسط انسان را از بین میبرد و انطباق ایمنی را افزایش میدهد.

در مقایسه با روشهای قبلی مانند RLHF و هوش مصنوعی قانونی، پاسخهای حساس به زمینه و ایمنتر را در طول استنتاج ممکن میسازد.

آموزش و روش شناسی

همسویی مشورتی نیز مبتنی بر نظارت است عملی و نظارت موجود نتیجه موارد استفاده:

آموزش با کارهای جانبی شروع می شود، به جز داده های ایمنی خاص.

پایگاه داده ای از راهنمایی در مورد استانداردهای ایمنی برای تنظیم دقیق ایجاد شده است.

یادگیری تقویتی با استفاده از سیگنال های پاداش مرتبط با رعایت ایمنی، مدل را بهبود می بخشد.

نتایج:

مدل O3 در استانداردهای ایمنی داخلی و خارجی بهتر از GPT-4o مدل های پیشرفته دیگر موفق شده اند.

پیشرفت های بزرگ در از خروجی های نامناسب اجتناب کنید و در عین حال اجازه پاسخ های مناسب را بدهید مورد توجه قرار گرفته است.

دسترسی زودهنگام و فرصت های تحقیق

اولین نسخه از مدل o3 در اوایل سال 2025 منتشر خواهد شد. OpenAI از محققان ایمنی و امنیت دعوت کرده است تا برای دسترسی زودهنگام اقدام کنند.

با پیچیده تر شدن مدل های استنتاج، OpenAI همچنان در اولویت تحقیقات ایمنی قرار دارد. این ابتکار با همکاری مداوم این شرکت با سازمانهایی مانند مؤسسه ایمنی هوش مصنوعی در ایالات متحده و بریتانیا هماهنگ است و اطمینان میدهد که پیشرفتهای هوش مصنوعی ایمن و مفید باقی میمانند.

برای دوستان خود ارسال کنید

منبع: https://toranji.ir/2024/12/21/%D9%85%D8%AF%D9%84-%D9%87%D8%A7%DB%8C-o3-%D9%88-o3-mini-%D9%87%D9%88%D8%B4-%D9%85%D8%B5%D9%86%D9%88%D8%B9%DB%8C-openai-%D8%A8%D8%A7-%D9%82%D8%A7%D8%A8%D9%84%DB%8C%D8%AA-%D8%A7%D8%B3%D8%AA%D8%AF%D9%84/

تحریریه ICTNN شبکه خبری